简述: 记录使用Pytorch进行Xavier初始化所遇到的问题。

本文初发于 “曾晨de小站” zengchen233.cn,同步转载于此。

在PyTorch中,通常不需要手动计算Xavier初始化的权重,因为PyTorch提供了内置的初始化方法,它会自动应用适当的初始化策略,根据你选择的权重初始化方法和激活函数类型。具体来说,你可以使用torch.nn.init模块中的函数来初始化神经网络的权重。

例如,你可以使用torch.nn.init.xavier_uniform_``torch.nn.init.xavier_normal_函数来执行Xavier初始化,具体取决于你想要使用的权重初始化的分布(均匀分布或正态分布):

import torch.nn.init as init

# 对于线性激活函数(如恒等激活函数)的Xavier初始化

init.xavier_uniform_(your_tensor) # 使用均匀分布初始化

# 或者

init.xavier_normal_(your_tensor) # 使用正态分布初始化

# 对于S型激活函数(例如sigmoid或tanh)的Xavier初始化

init.xavier_uniform_(your_tensor, gain=init.calculate_gain('sigmoid')) # 使用均匀分布初始化

# 或者

init.xavier_normal_(your_tensor, gain=init.calculate_gain('tanh')) # 使用正态分布初始化

在这些函数中,gain参数用于指定激活函数的增益(gain),以便计算Xavier初始化的方差。calculate_gain函数用于根据激活函数的名称自动计算增益。

因此,PyTorch会自动根据你的选择应用适当的初始化策略,你只需要使用适当的初始化函数并传递你要初始化的权重张量即可。这样可以确保神经网络的权重被正确初始化,从而更好地处理梯度流动问题。

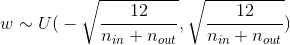

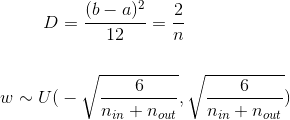

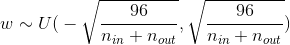

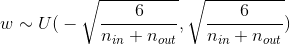

如果W服从正态分布,那么这就是所需要的参数,但如果假设W服从均匀分布,那么:

sigmoid:

tanh:

ReLU: